금주 캐치페이퍼는 Google DeepMind, Adobe, Apple, Toyota Research, Alibaba, Meta, ByteDance, NVIDIA, Microsoft와 함께합니다.

3분만 투자해 쓱 둘러보고, 빠르게 바뀌는 기술의 방향성을 놓치지 마세요!

📈 최신 AI 트렌드 2줄 요약

🌟 최근 AI 연구에서는 확산 모델(Diffusion Model)의 효율성 극대화와 비전 인코더의 새로운 활용법이 큰 주목을 받고 있습니다.

🚀 자율주행, 로보틱스, 비디오 생성 분야에서 통합 프레임워크와 실시간 처리 기술의 혁신이 활발히 진행되고 있으며, 특히 멀티모달 대형 언어 모델(MLLM)의 안전성과 효율성 연구가 부상하고 있습니다.

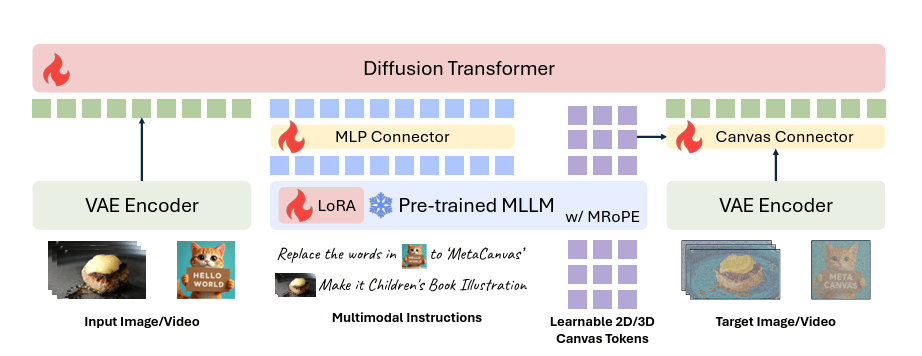

🖼️ DALL-E가 못하는 걸 Meta가 해냈다!

Exploring MLLM-Diffusion Information Transfer with MetaCanvas

🏛️ 소속: Meta Superintelligence Labs

🏷️ 핵심 키워드: MLLM, Latent Space Reasoning, Diffusion Generator

💭 이런 질문을 해본 적 있나요?

"대형 언어 모델이 이미지 생성을 직접 제어할 수 있을까?"

"레이아웃과 속성을 더 정밀하게 제어할 수 있는 방법이 있을까?"

"텍스트 이해와 이미지 생성을 하나로 통합할 수 있을까?"

오케스트라 지휘자가 모든 악기를 조율하듯, MetaCanvas는 MLLM이 잠재 공간에서 직접 추론하고 계획하여 확산 생성기와 연동합니다. 이를 통해 레이아웃 정확도와 속성 제어 정밀도가 크게 향상되며, 복잡한 프롬프트도 정확하게 반영됩니다. 특히 주목할 점:

MLLM의 추론 능력을 잠재 공간에서 직접 활용

레이아웃 및 속성 제어 정밀도 대폭 향상

복잡한 멀티 객체 시나리오에서도 일관된 성능

🎯 왜 이것이 게임 체인저인가? : 텍스트-이미지 분리 → MLLM-확산 통합 추론의 전환점 강조

🔗 더 자세한 내용이 궁금하다면 : https://arxiv.org/abs/2512.11464

⚡ 30분 걸리던 작업, 이제 6초면 끝!

🏛️ 소속: Google DeepMind, UCL

🏷️ 핵심 키워드: 4D Reconstruction, Query-based Transformer, Point Tracking

💭 이런 질문을 해본 적 있나요?

"동영상에서 3D 장면과 카메라 움직임을 동시에 복원할 수 있을까?"

"포인트 추적, 깊이 추정, 카메라 포즈를 하나의 모델로 통합할 수 있을까?"

"기존 방식보다 수백 배 빠른 추론이 가능할까?"

퍼즐 조각들을 순식간에 맞추는 마법사처럼, D4RT는 쿼리 기반 트랜스포머로 포인트 추적, 깊이 추정, 카메라 포즈를 동시에 해결합니다. 기존의 최적화 기반 방법들이 수십 분 걸리던 작업을 단 몇 초 만에 처리하며, 300배 이상의 속도 향상을 달성했습니다. 특히 주목할 점:

최적화 없이 피드포워드 추론만으로 고품질 4D 재구성 달성

기존 SOTA 대비 300배 빠른 추론 속도

다양한 동영상 시나리오에서 일관된 성능

🎯 왜 이것이 게임 체인저인가? : 느린 최적화 기반 재구성 → 실시간 피드포워드 4D 재구성의 전환점 강조

🔗 더 자세한 내용이 궁금하다면 : https://arxiv.org/abs/2512.08924

🎨 확산 모델 연구자들, 그동안 엉뚱한 곳만 파고 있었다…?

What matters for Representation Alignment: Global Information or Spatial Structure?

🏛️ 소속: NYU, Adobe Research

🏷️ 핵심 키워드: iREPA, Representation Alignment, Spatial Structure

💭 이런 질문을 해본 적 있나요?

"확산 모델의 표현 정렬에서 가장 중요한 요소는 무엇일까?"

"전역 의미 정보보다 더 중요한 것이 있을까?"

"더 효율적인 정렬 방법이 존재할까?"

GPS 위성이 전체 지구가 아닌 정확한 좌표 정보에 집중하듯, 이 연구는 확산 모델에서 전역 의미보다 공간 구조 정렬이 이미지 생성 품질에 더 결정적임을 밝혔습니다. 이를 바탕으로 제안된 iREPA는 기존 정렬 방법의 비효율성을 해결하고, 더 빠른 수렴과 향상된 생성 품질을 달성합니다. 특히 주목할 점:

공간 구조 정렬에 집중하여 불필요한 연산 제거

더 빠른 수렴 속도와 향상된 FID 점수

다양한 확산 모델 아키텍처에 적용 가능

🎯 왜 이것이 게임 체인저인가? : 전역 의미 중심 정렬 → 공간 구조 중심 정렬의 패러다임 전환점 강조

🔗 더 자세한 내용이 궁금하다면 : https://arxiv.org/abs/2512.10794

🔮 Apple이 복잡한 생성 모델들을 바보로 만들다!

One Layer Is Enough: Adapting Pretrained Visual Encoders for Image Generation

🏛️ 소속: Apple

🏷️ 핵심 키워드: Single Attention Layer, Vision Encoder Adaptation, FID 1.29

💭 이런 질문을 해본 적 있나요?

"복잡한 생성 모델 없이도 최고 수준의 이미지 생성이 가능할까?"

"사전학습된 비전 인코더를 이미지 생성에 효율적으로 활용할 수 있을까?"

"레이어를 줄여도 품질을 유지할 수 있을까?"

미니멀리스트 건축가가 단 하나의 기둥으로 웅장한 건물을 세우듯, FAE는 단일 어텐션 레이어만으로 사전학습된 비전 인코더를 이미지 생성에 적응시켜 ImageNet FID 1.29라는 놀라운 성과를 달성했습니다. 이는 복잡한 디코더 구조 없이도 최고 수준의 생성이 가능함을 증명합니다. 특히 주목할 점:

단일 어텐션 레이어로 복잡한 구조 대체

ImageNet 256×256에서 FID 1.29 달성

다양한 사전학습 인코더에 적용 가능

🎯 왜 이것이 게임 체인저인가? : 복잡한 생성 아키텍처 → 미니멀한 단일 레이어 적응의 전환점 강조

🔗 더 자세한 내용이 궁금하다면 : https://arxiv.org/abs/2512.07829

🤖 실제 로봇 데이터? 이제 안 모아도 됩니다.

AnchorDream: Repurposing Video Diffusion for Embodiment-Aware Robot Data Synthesis

🏛️ 소속: Toyota Research Institute, USC

🏷️ 핵심 키워드: Robot Data Synthesis, Video Diffusion, Motion Rendering

💭 이런 질문을 해본 적 있나요?

"로봇 학습에 필요한 대량의 데이터를 효율적으로 생성할 수 있을까?"

"실제 로봇 데이터 수집 없이도 다양한 시나리오를 학습시킬 수 있을까?"

"합성 데이터가 실제 로봇 성능을 얼마나 향상시킬 수 있을까?"

영화 감독이 CG로 불가능한 장면을 만들어내듯, AnchorDream은 로봇 모션 렌더링을 기반으로 비디오 확산 모델을 활용해 다양한 로봇 학습 데이터를 합성합니다. 이렇게 생성된 데이터로 학습한 로봇은 36.4%의 성능 향상을 보여주며, 데이터 부족 문제를 혁신적으로 해결합니다. 특히 주목할 점:

실제 데이터 수집 없이 고품질 학습 데이터 생성

36.4% 작업 성공률 향상 달성

다양한 로봇 조작 시나리오에 적용 가능

🎯 왜 이것이 게임 체인저인가? : 제한된 실제 데이터 수집 → 확산 기반 무한 데이터 합성의 전환점 강조

🔗 더 자세한 내용이 궁금하다면 : https://arxiv.org/abs/2512.11797

🎬 ???: Runway, Pika 긴장해라. 오픈소스가 따라잡았다ㅎ

Wan-Move: Motion-controllable Video Generation via Latent Trajectory Guidance

🏛️ 소속: Alibaba, Tsinghua University

🏷️ 핵심 키워드: Latent Trajectory, Motion Control, Video Generation

💭 이런 질문을 해본 적 있나요?

"생성된 비디오의 객체 움직임을 정밀하게 제어할 수 있을까?"

"상용 솔루션 수준의 품질을 오픈 모델로 달성할 수 있을까?"

"복잡한 모션 패턴도 자연스럽게 표현할 수 있을까?"

안무가가 댄서의 동선을 그리듯, Wan-Move는 잠재 공간에서 궤적을 가이드하여 비디오 속 객체의 움직임을 정밀하게 제어합니다. 기존의 조건부 생성 방식과 달리, 잠재 궤적 가이던스를 통해 상용 솔루션에 필적하는 품질과 자연스러운 모션을 동시에 달성합니다. 특히 주목할 점:

잠재 공간에서의 직접적 모션 제어

상용 솔루션과 동등한 품질 달성

다양한 모션 패턴에 일관되게 적용 가능

🎯 왜 이것이 게임 체인저인가? : 제한된 모션 제어 → 잠재 궤적 기반 정밀 제어의 전환점 강조

🔗 더 자세한 내용이 궁금하다면 : https://arxiv.org/abs/2512.08765

🚗 테슬라 FSD도 못 푸는 문제, ByteDance가 풀었다

UniUGP: Unifying Understanding, Generation, and Planing For End-to-end Autonomous Driving

🏛️ 소속: ByteDance

🏷️ 핵심 키워드: End-to-End Driving, Video Generation, Trajectory Planning

💭 이런 질문을 해본 적 있나요?

"자율주행의 인식, 예측, 계획을 하나의 모델로 통합할 수 있을까?"

"미래 장면을 생성하면서 동시에 주행 계획을 수립할 수 있을까?"

"희귀 상황에서도 안정적인 주행이 가능할까?"

한 명의 베테랑 드라이버가 상황 판단, 예측, 조작을 동시에 수행하듯, UniUGP는 장면 이해, 미래 비디오 생성, 궤적 계획을 통합한 엔드투엔드 자율주행 프레임워크입니다. 이를 통해 희귀 상황에서도 89%의 정확도를 달성하고, 단일 프론트 카메라만으로 1.23m의 계획 오차를 기록합니다. 특히 주목할 점:

세 가지 핵심 능력을 하나의 모델로 통합

희귀 객체 예측 89% 정확도 달성

다양한 주행 시나리오에서 일관된 성능

🎯 왜 이것이 게임 체인저인가? : 분리된 모듈 → 통합 이해-생성-계획 프레임워크의 전환점 강조

🔗 더 자세한 내용이 궁금하다면 : https://arxiv.org/abs/2512.09864

⚡ NVIDIA가 깊이 인식의 속도 한계를 부쉈다!

FoundationStereo: Zero-Shot Stereo Matching

🏛️ 소속: NVIDIA

🏷️ 핵심 키워드: Knowledge Distillation, Neural Architecture Search, Real-Time Stereo

💭 이런 질문을 해본 적 있나요?

"고품질 스테레오 매칭을 실시간으로 수행할 수 있을까?"

"대형 모델의 성능을 소형 모델로 전이할 수 있을까?"

"새로운 환경에서도 즉시 적용 가능한 스테레오 시스템이 가능할까?"

F1 레이싱카가 성능을 유지하면서 연비를 높이듯, Fast-FoundationStereo는 지식 증류와 신경망 아키텍처 검색을 통해 FoundationStereo 대비 10배 이상 빠른 속도를 달성하면서도 제로샷 성능을 유지합니다. 이는 로보틱스와 자율주행에서 실시간 깊이 인식을 가능하게 합니다. 특히 주목할 점:

10배 이상의 속도 향상과 품질 유지

실시간 처리와 제로샷 일반화 동시 달성

다양한 환경에서 즉시 적용 가능

🎯 왜 이것이 게임 체인저인가? : 느린 고품질 스테레오 → 실시간 제로샷 스테레오의 전환점 강조

🔗 더 자세한 내용이 궁금하다면 : https://arxiv.org/abs/2501.09898

🧠 GPT 구조의 치명적 약점이 드러났다

Causal Reasoning Favors Encoders: On The Limits of Decoder-Only Models

🏛️ 소속: Microsoft, IIIT

🏷️ 핵심 키워드: Causal Reasoning, Encoder vs Decoder, OOD Generalization

💭 이런 질문을 해본 적 있나요?

"인과 추론에서 어떤 아키텍처가 더 유리할까?"

"분포 외 데이터에서도 일반화할 수 있는 모델이 있을까?"

"논리적 불변성을 보존하는 모델은 무엇일까?"

탐정이 단서들의 인과관계를 파악하듯, 이 연구는 구조화된 인과 추론에서 인코더 기반 모델이 디코더 전용 모델보다 분포 외(OOD) 일반화와 논리 불변성 보존에서 우수함을 밝혔습니다. 이는 LLM 아키텍처 선택에 중요한 시사점을 제공합니다. 특히 주목할 점:

인과 구조를 더 효과적으로 학습하는 인코더

OOD 상황에서 월등한 일반화 성능

다양한 인과 추론 벤치마크에서 일관된 우위

🎯 왜 이것이 게임 체인저인가? : 디코더 중심 LLM → 인과 추론에 최적화된 인코더의 전환점 강조

🔗 더 자세한 내용이 궁금하다면 : https://arxiv.org/abs/2512.10561

🔐 AI가 학습한 당신의 얼굴, 이제 지울 수 있다!

MLLM Machine Unlearning via Visual Knowledge Distillation

🏛️ 소속: Xidian University, Amazon

🏷️ 핵심 키워드: Machine Unlearning, Visual Knowledge Distillation, Privacy Protection

💭 이런 질문을 해본 적 있나요?

"학습된 AI 모델에서 특정 정보만 선택적으로 삭제할 수 있을까?"

"시각적 민감 정보를 제거하면서 모델 성능을 유지할 수 있을까?"

"재학습 없이 효율적으로 정보를 잊게 할 수 있을까?"

정밀 외과 수술처럼, 이 연구는 시각 지식 증류(VKD)를 통해 MLLM에서 민감한 시각 정보만 선택적으로 제거합니다. 전체 모델을 재학습하지 않고도 개인정보 보호와 저작권 문제를 해결할 수 있으며, 효율성과 효과성을 모두 향상시킵니다. 특히 주목할 점:

시각 정보만 타겟팅하여 정밀한 삭제 가능

모델 성능 저하 최소화하며 완전한 삭제 달성

다양한 MLLM 아키텍처에 적용 가능

🎯 왜 이것이 게임 체인저인가? : 전체 재학습 → 선택적 시각 지식 삭제의 전환점 강조

🔗 더 자세한 내용이 궁금하다면 : https://arxiv.org/abs/2512.11464

매일 화요일 오전 8시,

바쁜 당신을 기술 발전에 뒤쳐지지 않게 만들어줄

최신 AI 트렌드가 요약 정리본으로 전달됩니다!