금주 캐치페이퍼는 Google DeepMind, Microsoft, Meta, Alibaba, OpenAI, Tencent, NUS, Fudan University와 함께합니다.

3분만 투자해 쓱 둘러보고, 빠르게 바뀌는 기술의 방향성을 놓치지 마세요!

📈 최신 AI 트렌드 3줄 요약

🌟 AI 에이전트 시스템의 메모리, 적응성, 안전성에 대한 체계적 연구가 활발히 진행되고 있으며, 특히 여러 AI가 협력하여 AGI 수준의 지능을 발현할 수 있다는 'Patchwork AGI' 개념이 주목받고 있습니다.

🚀 LLM의 효율성 극대화를 위한 극단적 희소성(Extreme Sparsity) MoE 모델과 긴 컨텍스트 처리를 위한 Test-Time Training 기법 등 실용적 성능 향상 연구가 두드러집니다.

🔥미국 기업을 누르려는 중국의 움직임 - 오픈소스 공세가 눈에 띄는 주입니다.

🚨 DeepMind가 경고한 '좀비 AI 군단' 시나리오

Distributional AGI Safety

🏛️ 소속: Google DeepMind

🏷️ 핵심 키워드: Patchwork AGI, Defense-in-Depth, Agentic Sandbox

💭 이런 질문을 해본 적 있나요?

"AGI는 반드시 하나의 거대한 모델이어야 할까?"

"여러 특화된 AI가 협력하면 어떤 위험이 생길까?"

"분산된 AI 시스템의 안전은 어떻게 보장할 수 있을까?"

개미 군집이 개별 개미보다 훨씬 복잡한 문제를 해결하듯, 특화된 여러 AI 에이전트가 협력하면 단일 모델을 넘어서는 'Patchwork AGI'가 출현할 수 있습니다. Google DeepMind는 이러한 분산형 AGI의 위험에 대응하는 다층 방어 프레임워크를 제안했습니다. 특히 주목할 점:

단일 모델 안전성을 넘어 집단적 위험까지 포괄

시장 설계, 모니터링, 규제 메커니즘을 통합한 종합적 접근

가상 에이전트 샌드박스 경제에서 검증 가능

🎯 왜 이것이 게임 체인저인가? : 단일 모델 안전성 → 분산 AI 시스템의 집단적 안전성 관리로의 전환점

🔗 더 자세한 내용이 궁금하다면 : 논문 링크

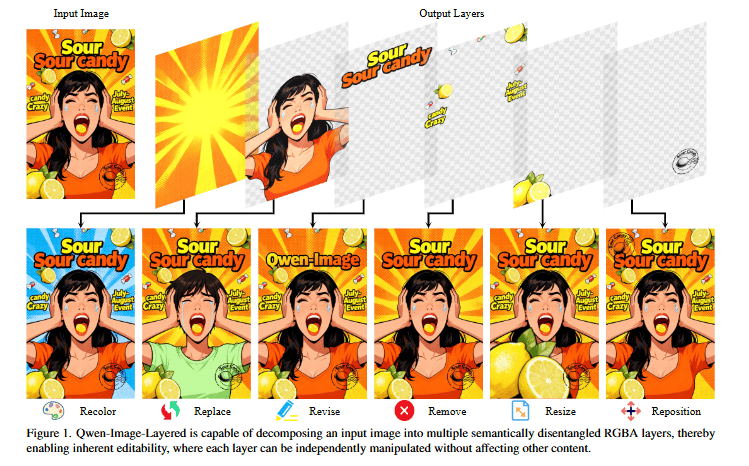

📐 알리바바의 어도비 사냥 : 포토샵 킬러의 등장

Qwen-Image-Layered: Towards Inherent Editability via Layer Decomposition

🏛️ 소속: Alibaba (Qwen Team)

🏷️ 핵심 키워드: Layer Decomposition, RGBA, Image Editing, VLD-MMDiT

💭 이런 질문을 해본 적 있나요?

"AI가 포토샵처럼 레이어를 자동으로 분리해줄 수 있을까?"

"배경만 바꾸고 싶은데 왜 매번 전체 이미지가 망가질까?"

"이미지 편집의 일관성 문제를 근본적으로 해결할 수 있을까?"

포토샵 장인이 수십 분 걸려 하던 레이어 분리 작업을 AI가 단번에 해냅니다. Qwen-Image-Layered는 단일 RGB 이미지를 의미적으로 분리된 여러 RGBA 레이어로 자동 분해하여, 각 레이어를 독립적으로 편집해도 다른 요소에 영향을 주지 않습니다. 실제 PSD 파일에서 학습한 이 모델은 전문 디자인 도구 수준의 레이어 구조를 AI로 구현했습니다. 특히 주목할 점:

이미지 편집 시 일관성 문제를 레이어 분리로 근본 해결

가변 길이 레이어 분해로 3~8개 이상 유연한 분리 가능

Apache 2.0 라이선스로 상업적 사용까지 완전 무료

🎯 왜 이것이 게임 체인저인가? : 평면 래스터 이미지 편집 → 자동 레이어 분리 기반 편집의 전환점 강조

🔗 더 자세한 내용이 궁금하다면 : https://arxiv.org/abs/2512.15603

💰 "20B 모델인데 0.5B만 쓴다고?" Microsoft의 미친 효율, 경쟁사 다 죽인다

Sigma-MoE-Tiny Technical Report

🏛️ 소속: Microsoft

🏷️ 핵심 키워드: Mixture-of-Experts, Extreme Sparsity, Progressive Sparsification

💭 이런 질문을 해본 적 있나요?

"모델 파라미터의 2.5%만 사용해도 최고 성능을 낼 수 있을까?"

"극단적인 희소성에서 학습 안정성을 어떻게 유지할까?"

"MoE 모델의 전문가 부하 균형 문제를 해결할 수 있을까?"

거대한 도서관에서 필요한 책 한 권만 정확히 찾아내는 것처럼, Sigma-MoE-Tiny는 레이어당 96개의 전문가 중 단 1개만 활성화합니다. 20B 파라미터 중 0.5B만 사용하면서도 동급 또는 더 큰 모델들을 능가하는 성능을 보여줍니다. 특히 주목할 점:

오픈소스 모델 중 가장 높은 희소성 달성

점진적 희소화 스케줄로 학습 안정성 확보

손실 스파이크 없이 안정적인 전체 학습 과정

🎯 왜 이것이 게임 체인저인가? : 일반적인 MoE 희소성 → 극단적 희소성(2.5%)에서도 최고 성능 달성의 전환점

🔗 더 자세한 내용이 궁금하다면 : 논문 링크

🧠 AI가 치매 걸리는 이유? NUS가 '에이전트 기억력'의 비밀을 풀었다

Memory in the Age of AI Agents

🏛️ 소속: National University of Singapore, Fudan University

🏷️ 핵심 키워드: Agent Memory, Unified Framework, Memory Architecture

💭 이런 질문을 해본 적 있나요?

"AI 에이전트의 메모리는 RAG나 LLM 메모리와 어떻게 다를까?"

"장기 기억과 단기 기억을 AI에서 어떻게 구현할까?"

"에이전트 메모리의 미래 발전 방향은 무엇일까?"

인간의 뇌가 해마와 대뇌피질로 기억을 나누어 관리하듯, 이 서베이는 AI 에이전트 메모리를 아키텍처, 기능적 역할, 작동 역학으로 체계화했습니다. LLM 메모리, RAG와의 명확한 구분을 통해 급변하는 분야의 로드맵을 제시합니다. 특히 주목할 점:

에이전트 메모리에 대한 최초의 통합 프레임워크

유사 개념들과의 명확한 경계 설정

다양한 에이전트 시스템에 적용 가능한 일반화된 분류체계

🎯 왜 이것이 게임 체인저인가? : 산발적인 메모리 연구 → 통합된 에이전트 메모리 프레임워크의 전환점

🔗 더 자세한 내용이 궁금하다면 : 논문 링크

📚 "컨텍스트 길어지면 바보 된다"던 LLM, Meta가 실시간으로 고쳐버림

Let's (not) just put things in Context: Test-Time Training for Long-Context LLMs

🏛️ 소속: Meta, Harvard University, OpenAI

🏷️ 핵심 키워드: Query-only TTT, Score Dilution, Long-Context

💭 이런 질문을 해본 적 있나요?

"긴 컨텍스트에서 정보가 희석되는 문제를 해결할 수 있을까?"

"추론 시점에 모델을 동적으로 조정할 수 있을까?"

"재학습 없이 긴 문서 이해 능력을 향상시킬 수 있을까?"

방대한 자료실에서 필요한 정보를 즉시 찾아내는 사서처럼, qTTT는 추론 시점에 어텐션 메커니즘을 동적으로 조정합니다. 'Score Dilution' 문제를 해결하여 LongBench-v2에서 12.6%, ZeroScrolls에서 14.1%의 성능 향상을 달성했습니다. 특히 주목할 점:

재학습 없이 추론 시점에서 성능 향상

Score Dilution 문제에 대한 최초의 체계적 해결책

다양한 긴 컨텍스트 벤치마크에서 일관된 개선

🎯 왜 이것이 게임 체인저인가? : 정적인 컨텍스트 처리 → 동적 Test-Time 적응의 전환점

🔗 더 자세한 내용이 궁금하다면 : 논문 링크

🔮 "다음 단어만 예측한다"는 건 거짓말? Google DeepMind가 밝힌 OpenAI GPT의 숨겨진 초능력

Autoregressive Language Models are Secretly Energy-Based Models

🏛️ 소속: Google DeepMind

🏷️ 핵심 키워드: ARM-EBM Bijection, Lookahead Capability, Soft Value Function

💭 이런 질문을 해본 적 있나요?

"다음 토큰 예측만으로 어떻게 문맥을 이해할 수 있을까?"

"자기회귀 모델이 미래 시퀀스를 고려할 수 있을까?"

"Teacher Forcing이 왜 효과적인지 이론적으로 설명할 수 있을까?"

체스 선수가 다음 한 수를 두면서도 여러 수 앞을 내다보듯, 자기회귀 모델(ARM)이 사실은 에너지 기반 모델(EBM)과 수학적으로 동치임을 증명했습니다. 이로써 ARM이 'Soft Value Function'을 통해 암묵적으로 미래를 예측하는 능력을 갖추고 있음을 밝혔습니다. 특히 주목할 점:

ARM과 EBM의 이론적 통합

Teacher Forcing의 최적성에 대한 최초의 이론적 증명

함수 공간에서의 일반적인 증명으로 모든 ARM에 적용

🎯 왜 이것이 게임 체인저인가? : ARM의 단순 다음 토큰 예측 → 암묵적 미래 예측 능력 발견의 전환점

🔗 더 자세한 내용이 궁금하다면 : 논문 링크

🎨 GPT-4o 성능을 공짜로? Alibaba가 공개한 '머릿속 스케치' 기술

Sketch-in-Latents: Eliciting Unified Reasoning in MLLMs

🏛️ 소속: Huazhong University of Science and Technology, Alibaba Cloud Computing

🏷️ 핵심 키워드: SkiLa, Latent Visual Thoughts, Unified Reasoning

💭 이런 질문을 해본 적 있나요?

"AI가 이미지를 '머릿속에서' 그려보며 추론할 수 있을까?"

"텍스트 사고와 시각적 사고를 통합할 수 있을까?"

"추가 비용 없이 멀티모달 추론을 향상시킬 수 있을까?"

건축가가 머릿속으로 건물을 상상하며 설계하듯, SkiLa는 MLLM이 텍스트 사고와 잠재적 시각 사고를 동적으로 결합하게 합니다. 추가 추론 비용 없이 GPT-4o급 성능을 달성하며, 비전 중심 과제에서 특히 뛰어난 성과를 보입니다. 특히 주목할 점:

추가 추론 비용 없이 성능 향상

GPT-4o와 경쟁하는 오픈소스 솔루션

비전 중심 및 일반 멀티모달 태스크 모두에서 개선

🎯 왜 이것이 게임 체인저인가? : 분리된 텍스트/시각 추론 → 통합된 잠재 공간 추론의 전환점

🔗 더 자세한 내용이 궁금하다면 : 논문 링크

🦎 AI 에이전트 '적응력' 올리는 4가지 비법, 이 논문 하나로 정리 끝

Adaptation of Agentic AI

🏛️ 소속: UIUC, Stanford, Princeton, Harvard, UW, Caltech, UCBerkeley, UCSD, GeorgiaTech 등 (다수 유명대학 연구)

🏷️ 핵심 키워드: Adaptation Taxonomy, Four Paradigms, Emergent Patterns

💭 이런 질문을 해본 적 있나요?

"AI 에이전트가 새로운 환경에 적응하는 최적의 방법은?"

"다양한 적응 전략의 장단점을 어떻게 비교할까?"

"데이터 효율적인 적응 패턴은 무엇일까?"

카멜레온이 환경에 따라 색을 바꾸듯, 이 연구는 AI 에이전트의 적응 전략을 최적화 대상과 적응 신호 소스에 따라 4가지 패러다임으로 분류합니다. 데이터 효율성과 모듈성을 개선하는 새로운 아키텍처 패턴도 제시합니다. 특히 주목할 점:

최초의 체계적인 적응 전략 분류체계

각 패러다임의 트레이드오프 명확화

더 강건하고 확장 가능한 에이전트 구축 가이드라인 제공

🎯 왜 이것이 게임 체인저인가? : 임의적 적응 방식 → 체계적 4-패러다임 분류의 전환점

🔗 더 자세한 내용이 궁금하다면 : 논문 링크

🧭 "보상 모델 없이 스스로 똑똑해진다?" LLM 자기 강화학습의 새 시대

Can LLMs Guide Their Own Exploration? Gradient-Guided RL for LLM Reasoning

🏛️ 소속: Tencent

🏷️ 핵심 키워드: G2RL, Gradient-Guided Exploration, Self-Improvement

💭 이런 질문을 해본 적 있나요?

"LLM이 외부 도움 없이 스스로 더 나은 추론을 학습할 수 있을까?"

"강화학습에서 탐색의 효율성을 높일 수 있을까?"

"모델 내재적 신호로 학습을 안정화할 수 있을까?"

나침반이 자기장을 따라 방향을 찾듯, G2RL은 모델의 그래디언트 업데이트를 활용해 LLM의 탐색 방향을 안내합니다. 외부 보상 모델 없이도 수학 및 일반 추론 벤치마크에서 일관된 성능 향상과 안정적인 학습을 달성합니다. 특히 주목할 점:

외부 보상 모델 없이 자기 개선 가능

그래디언트 기반의 효율적이고 안정적인 탐색

수학 및 일반 추론 벤치마크 전반에서 일관된 개선

🎯 왜 이것이 게임 체인저인가? : 외부 보상 의존 탐색 → 자기 그래디언트 기반 탐색의 전환점

🔗 더 자세한 내용이 궁금하다면 : 논문 링크

📊 데이터 노가다 끝? LLM이 알아서 학습 데이터까지 만들어준다

DataFlow: An LLM-Driven Framework for Unified Data Preparation

🏛️ 소속: Peking University, Institute for Advanced Algorithms Research, OriginHub Technology, OpenDataLab

🏷️ 핵심 키워드: Data-Centric AI, Workflow Automation, Data Synthesis

💭 이런 질문을 해본 적 있나요?

"데이터 준비 과정을 자동화할 수 있을까?"

"더 작은 고품질 데이터셋으로 SOTA를 달성할 수 있을까?"

"데이터 합성과 정제를 통합할 수 있을까?"

숙련된 요리사가 재료 선별부터 조리까지 일관되게 관리하듯, DataFlow는 LLM을 활용해 데이터 준비와 워크플로우를 통합 자동화합니다. 더 작은 데이터셋으로도 다양한 태스크에서 SOTA 성능을 달성하거나 초과합니다. 특히 주목할 점:

데이터 준비부터 정제까지 통합 자동화

더 작은 데이터셋으로 동등하거나 우수한 성능

다양한 태스크에서 일관된 SOTA 달성

🎯 왜 이것이 게임 체인저인가? : 수동 데이터 준비 → LLM 기반 자동화된 데이터 워크플로우의 전환점

🔗 더 자세한 내용이 궁금하다면 : 논문 링크

👁️ "디코더만 쓰면 된다"는 상식 깨졌다: 128K 토큰 처리하는 경량 모델의 역습

T5Gemma 2: Seeing, Reading, and Understanding Longer

🏛️ 소속: Google DeepMind

🏷️ 핵심 키워드: Encoder-Decoder, 128K Context, Multilingual Multimodal

💭 이런 질문을 해본 적 있나요?

"인코더-디코더 구조가 디코더 전용 모델을 이길 수 있을까?"

"다국어, 멀티모달, 긴 컨텍스트를 동시에 지원할 수 있을까?"

"경량 모델로 128K 토큰을 처리할 수 있을까?"

능숙한 통역사가 긴 연설을 듣고 핵심을 정확히 전달하듯, T5Gemma 2는 경량 인코더-디코더 구조로 128K 토큰의 긴 컨텍스트를 이해합니다. 다국어와 멀티모달 인식까지 지원하며 Gemma 3 디코더 전용 모델과 동등하거나 우수한 성능을 보입니다. 특히 주목할 점:

인코더-디코더의 구조적 효율성 활용

디코더 전용 Gemma 3와 동등하거나 우수한 성능

다국어, 멀티모달, 128K 긴 컨텍스트 동시 지원

🎯 왜 이것이 게임 체인저인가? : 디코더 전용 트렌드 → 인코더-디코더의 재도약 전환점

🔗 더 자세한 내용이 궁금하다면 : 논문 링크

매주 화요일 오전 8시,

바쁜 당신을 기술 발전에 뒤쳐지지 않게 만들어줄

최신 AI 트렌드가 요약 정리본으로 전달됩니다!