금주 캐치페이퍼는 DeepSeek, MIT, Google, Tencent, Meta, Google DeepMind, Alibaba, NUS, Fudan과 함께합니다. 3분만 투자해 쓱 둘러보고, 빠르게 바뀌는 기술의 방향성을 놓치지 마세요!

📈 최신 AI 트렌드 3줄 요약

🌟 연말연초를 맞아 LLM의 근본적 한계를 극복하려는 연구들이 폭발적으로 쏟아지고 있습니다. (구독자 여러분, 새해 복 많이 받으세요!)

🔥 특히 장문 컨텍스트 처리와 에이전트 시스템의 효율화가 핵심 화두입니다.

🚀 인지과학과 AI의 융합, 그리고 AI 공동연구자(Co-Scientist) 개념이 본격적으로 등장하며, AI가 단순 도구를 넘어 연구 파트너로 진화하고 있습니다.

🔥 LLM 학습이 폭주해도 괜찮다고? DeepSeek의 "마법의 안전장치"

mHC: Manifold-Constrained Hyper-Connections

🏛️ 소속: DeepSeek-AI

🏷️ 핵심 키워드: Manifold Projection, Hyper-Connections, Training Stability

💭 이런 질문을 해본 적 있나요?

"대규모 LLM 학습 중 신호가 폭발해서 학습이 멈춘 경험이 있으신가요?"

"다양한 잔차 연결을 쓰고 싶은데, 불안정성이 걱정되시나요?"

"학습 오버헤드 6.7%만 추가하면 성능이 2.1% 오른다면?"

롤러코스터가 탈선하지 않도록 레일을 설계하듯, mHC는 매니폴드 투영으로 다양한 잔차 연결의 신호 폭발을 억제합니다. 27B 모델에서 BBH 벤치마크 2.1% 향상이라는 실질적 성과를 달성했습니다. 특히 주목할 점:

학습 불안정성 문제를 근본적으로 해결

단 6.7% 오버헤드로 안정성과 성능 동시 확보

대규모 모델일수록 효과가 극대화

🎯 왜 이것이 게임 체인저인가? : 불안정한 대규모 학습 → 수학적으로 보장된 안정적 학습의 전환점

🔗 더 자세한 내용이 궁금하다면 : https://arxiv.org/abs/2512.24880

🤯 1000만 토큰? GPT도 못하는 걸 MIT가 해냈다

Recursive Language Models

🏛️ 소속: MIT

🏷️ 핵심 키워드: Recursive Processing, Python REPL, Ultra-Long Context

💭 이런 질문을 해본 적 있나요?

"1000만 토큰짜리 문서를 LLM에 넣을 수 있다면?"

"컨텍스트 윈도우 한계를 프로그래밍으로 뚫을 수 있을까?"

"기존 LLM을 수정 없이 초장문 처리기로 만들 수 있다면?"

마트료시카 인형처럼, RLM은 거대한 입력을 재귀적으로 쪼개어 처리합니다. Python REPL 환경에서 모델이 스스로 컨텍스트를 탐색하고 조합하는 방식으로, 1000만 토큰 이상도 처리 가능합니다. 특히 주목할 점:

직접 LLM 호출 대비 압도적 성능

다른 스케일링 방법론 대비 강건성 입증

다양한 장문 컨텍스트 태스크에서 일관된 성과

🎯 왜 이것이 게임 체인저인가? : 컨텍스트 윈도우의 물리적 한계 → 재귀적 처리를 통한 무한 확장 가능성의 전환점

🔗 더 자세한 내용이 궁금하다면 : https://arxiv.org/abs/2512.24601

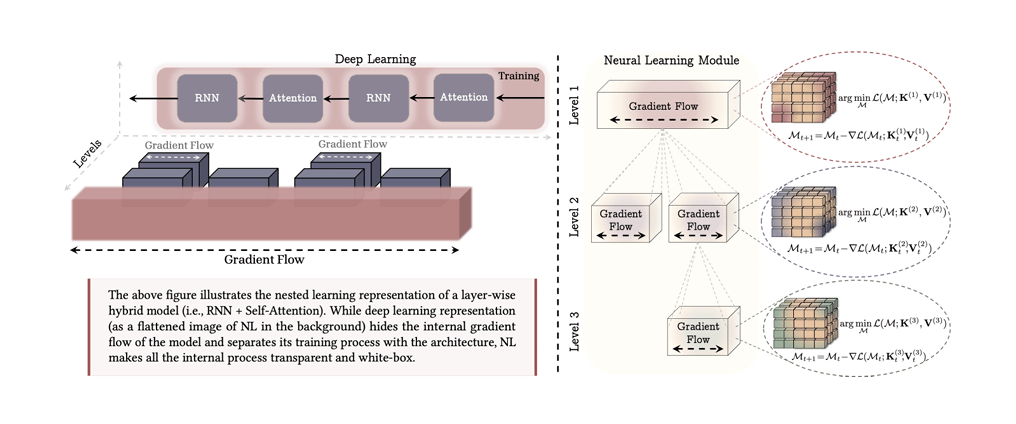

💀 구글이 나섰다: "딥러닝 아키텍처의 정의를 다시 해봅시다" - 중첩 학습 패러다임

Nested Learning: The Illusion of Deep Learning Architectures

🏛️ 소속: Google, Columbia University

🏷️ 핵심 키워드: Nested Optimization, Catastrophic Forgetting, Hope Architecture

💭 이런 질문을 해본 적 있나요?

"왜 AI는 새로운 걸 배우면 이전 것을 잊어버릴까요?"

"정적 모델의 한계를 극복할 방법은 없을까요?"

"연속 학습에서 치명적 망각을 막을 수 있다면?"

레고 블록을 쌓듯 여러 층위의 최적화를 중첩시킨 Nested Learning은 기존 딥러닝의 근본적 한계를 지적합니다. 새로운 Hope 아키텍처와 M3 옵티마이저로 연속 학습 성능을 획기적으로 개선했습니다. 특히 주목할 점:

치명적 망각 문제 완화

장문 컨텍스트 이해력 향상

다양한 태스크에서 일관된 개선

🎯 왜 이것이 게임 체인저인가? : 정적 모델의 한계 → 동적 다층 최적화 패러다임으로의 전환점

🔗 더 자세한 내용이 궁금하다면 : https://arxiv.org/abs/2512.24695

🧠 토큰 대신 "개념"으로 사고하는 AI가 나타났다

Dynamic Large Concept Models

🏛️ 소속: ByteDance Seed

🏷️ 핵심 키워드: Semantic Concepts, Hierarchical Modeling, Compressed Reasoning

💭 이런 질문을 해본 적 있나요?

"AI가 단어 단위가 아닌 의미 단위로 생각할 수 있다면?"

"추론 효율성을 높이면서 정확도도 올릴 수 있을까?"

"인간처럼 개념을 압축해서 사고하는 AI는 불가능할까?"

인간이 글을 읽을 때 단어 하나하나가 아닌 의미 덩어리로 파악하듯, DLCM은 텍스트를 가변 길이 의미 개념으로 동적 분할합니다. 12개 제로샷 벤치마크에서 평균 +2.69% 정확도 향상을 달성했습니다. 특히 주목할 점:

동일 연산량에서 추론 집약적 태스크 성능 향상

LLaMA 스타일 베이스라인 대비 우위

추론이 필요한 다양한 태스크에 적용 가능

🎯 왜 이것이 게임 체인저인가? : 토큰 기반 처리 → 의미 개념 기반 계층적 추론의 전환점

🔗 더 자세한 내용이 궁금하다면 : https://arxiv.org/abs/2512.24617

🐜 2B 파라미터로 GPT-4급? 텐센트의 "작은 거인"

Youtu-LLM: Unlocking the Native Agentic Potential for Lightweight Large Language Models

🏛️ 소속: Tencent

🏷️ 핵심 키워드: Lightweight LLM, Agentic Capability, Efficient Processing

💭 이런 질문을 해본 적 있나요?

"작은 모델로도 에이전트 능력을 발휘할 수 있을까?"

"2B 파라미터가 100B급 모델을 이길 수 있다면?"

"효율적인 장문 컨텍스트 처리가 가능한 소형 모델은?"

다윗이 골리앗을 이기듯, 1.96B 파라미터의 Youtu-LLM은 체계적 사전학습으로 네이티브 에이전트 능력을 확보했습니다. 일반 벤치마크와 에이전트 벤치마크 모두에서 SOTA를 달성했습니다. 특히 주목할 점:

경량 모델 중 최고 성능

더 큰 LLM과 동등하거나 우월한 성능

효율적인 장문 컨텍스트 처리 능력

🎯 왜 이것이 게임 체인저인가? : 크기 = 성능이라는 공식 → 효율적 사전학습으로 소형 모델의 재정의 전환점

🔗 더 자세한 내용이 궁금하다면 : https://arxiv.org/abs/2512.24618

⚡ 128K 토큰에서 2.7배 빠르다고? "테스트할 때 학습하는" AI

End-to-End Test-Time Training for Long Context

🏛️ 소속: Astera Institute, NVIDIA, Stanford University, UC Berkeley, UC San Diego

🏷️ 핵심 키워드: Test-Time Training, Long Context, Inference Speedup

💭 이런 질문을 해본 적 있나요?

"추론 시간에 모델이 스스로 적응할 수 있다면?"

"풀 어텐션의 성능을 유지하면서 속도를 2배 이상 높일 수 있을까?"

"슬라이딩 윈도우의 한계를 극복할 방법은?"

마라톤 선수가 레이스 중에도 컨디션을 조절하듯, TTT-E2E는 추론 시간에 모델을 적응시킵니다. 128K 컨텍스트에서 풀 어텐션 대비 2.7배 속도 향상을 달성하면서도 성능은 동등합니다. 특히 주목할 점:

리커런트 모델의 효율성 + 풀 어텐션의 성능

슬라이딩 윈도우를 최고 성능 방법으로 변환

확장된 시퀀스에서 일관된 효과

🎯 왜 이것이 게임 체인저인가? : 학습과 추론의 분리 → 추론 시간 적응을 통한 효율성 극대화의 전환점

🔗 더 자세한 내용이 궁금하다면 : https://arxiv.org/abs/2512.23675

🔬 AI가 과학자를 대체한다? Meta의 "AI 공동연구자"

Training AI Co-Scientists Using Rubric Rewards

🏛️ 소속: Meta Superintelligence Labs, Max Planck Institute, University of Cambridge

🏷️ 핵심 키워드: AI Co-Scientist, Rubric Learning, Research Planning

💭 이런 질문을 해본 적 있나요?

"AI가 연구 계획을 대신 세워줄 수 있다면?"

"과학 논문에서 자동으로 연구 목표와 평가 기준을 추출할 수 있을까?"

"인간 전문가가 70% 선호하는 AI 연구 파트너가 존재한다면?"

연구실의 선배처럼, AI Co-Scientist는 과학 문헌에서 연구 목표와 채점 기준을 자동 추출해 스스로를 훈련합니다. 인간 전문가 70% 선호, 루브릭 만족도 10-15% 향상이라는 놀라운 결과를 보여줍니다. 특히 주목할 점:

다양한 과학 분야에서 고품질 연구 계획 생성

자기 채점 강화학습으로 지속적 개선

확장 가능한 훈련 방법론

🎯 왜 이것이 게임 체인저인가? : AI 도구 → AI 연구 파트너로의 전환점

🔗 더 자세한 내용이 궁금하다면 : https://arxiv.org/abs/2512.23707

🗺️ 알리바바 지도 AI, GPT-4를 이기다

AMAP Agentic Planning Technical Report

🏛️ 소속: Alibaba Amap

🏷️ 핵심 키워드: Spatio-Temporal Reasoning, Route Planning, STAgent

💭 이런 질문을 해본 적 있나요?

"실시간 시공간 추론이 가능한 AI가 있다면?"

"멀티모달 경로 계획에서 GPT-4를 이길 수 있을까?"

"범용 모델 대신 특화된 에이전트가 더 나을까?"

네비게이션이 실시간으로 최적 경로를 찾듯, STAgent는 실세계 시공간 추론과 복잡한 계획 수립에 특화되었습니다. 멀티모달 경로 계획과 POI 발견에서 더 큰 범용 모델을 능가합니다. 특히 주목할 점:

특화 도메인에서 압도적 성능

범용 추론과 도구 사용 능력 유지

실세계 적용에 강건함

🎯 왜 이것이 게임 체인저인가? : 범용 LLM의 한계 → 도메인 특화 에이전트의 우위 입증 전환점

🔗 더 자세한 내용이 궁금하다면 : https://arxiv.org/abs/2512.24957

🕸️ RAG의 한계를 뚫다: "하이퍼그래프 메모리"의 등장

Improving Multi-step RAG with Hypergraph-based Memory for Long-Context Complex Relational Modeling

🏛️ 소속: The Chinese University of Hong Kong, WeChat AI

🏷️ 핵심 키워드: Hypergraph Memory, Multi-step RAG, N-ary Relations

💭 이런 질문을 해본 적 있나요?

"RAG가 복잡한 다중 관계를 이해하지 못해 답답했던 적 있나요?"

"여러 단계의 추론이 필요한 질문에 RAG가 실패한 경험이 있나요?"

"장문 컨텍스트에서 전역적 이해가 가능한 RAG는 없을까?"

거미줄처럼 복잡한 관계를 한눈에 파악하듯, HGMEM은 n-ary 관계를 동적으로 모델링하는 하이퍼그래프 메모리입니다. 병합 같은 연산을 통해 진화하며, 작은 모델로도 효율적입니다. 특히 주목할 점:

장문 컨텍스트에서 전역적 이해력 향상

경쟁 RAG 베이스라인 대비 우위

작은 모델에서도 효율적

🎯 왜 이것이 게임 체인저인가? : 단순 검색 기반 RAG → 복잡한 관계 모델링이 가능한 RAG의 전환점

🔗 더 자세한 내용이 궁금하다면 : https://arxiv.org/abs/2512.23959

🧬 뇌과학자들이 AI를 설계한다면?

AI Meets Brain: Memory Systems from Cognitive Neuroscience to Autonomous Agents

🏛️ 소속: National University of Singapore, Fudan University

🏷️ 핵심 키워드: Cognitive Memory, LLM Agents, Neuroscience Framework

💭 이런 질문을 해본 적 있나요?

"인간의 기억 시스템을 AI에 이식할 수 있다면?"

"인지신경과학 인사이트가 AI 에이전트를 어떻게 바꿀까?"

"생물학적 기억과 인공지능 기억의 통합이 가능할까?"

인간의 뇌를 역설계하듯, 이 서베이는 인지신경과학의 기억 시스템 인사이트를 LLM 에이전트에 통합합니다. 기억의 정의, 분류, 저장, 관리를 아우르는 통합 프레임워크와 평가 벤치마크를 제시합니다. 특히 주목할 점:

생물학-AI 통합 관점 제시

보안 측면까지 포괄하는 종합적 검토

자율 에이전트 설계의 새 방향 제시

🎯 왜 이것이 게임 체인저인가? : 공학적 접근 → 인지과학 기반 AI 설계의 전환점

🔗 더 자세한 내용이 궁금하다면 : https://arxiv.org/abs/2512.23343

🔮 AI의 "생각"을 들여다보다: 구글 딥마인드의 추론 해부학

Fantastic Reasoning Behaviors and Where to Find Them

🏛️ 소속: Google DeepMind, The University of Texas at Austin

🏷️ 핵심 키워드: Sparse Autoencoders, Reasoning Control, RISE Framework

💭 이런 질문을 해본 적 있나요?

"AI가 어떻게 추론하는지 들여다볼 수 있다면?"

"반성, 확신 같은 추론 행동을 실시간으로 제어할 수 있을까?"

"수학 문제에서 정확도를 높이면서 토큰 사용은 줄일 수 있다면?"

MRI가 뇌를 스캔하듯, RISE 프레임워크는 희소 오토인코더로 LLM 내부의 추론 행동을 비지도 발견합니다. 반성, 확신 같은 해석 가능한 추론 벡터를 식별하고 실시간 제어가 가능합니다. 특히 주목할 점:

수학 태스크에서 최대 4.66점 정확도 향상

13.69% 토큰 절감과 성능 향상 동시 달성

세밀한 실시간 추론 제어 가능

🎯 왜 이것이 게임 체인저인가? : 블랙박스 추론 → 해석 가능하고 제어 가능한 추론의 전환점

🔗 더 자세한 내용이 궁금하다면 : https://arxiv.org/abs/2512.23988

🤖 에이전트를 자동 생성하고 스스로 진화시킨다

Youtu-Agent: Scaling Agent Productivity with Automated Generation and Hybrid Policy Optimization

🏛️ 소속: Tencent Youtu Lab

🏷️ 핵심 키워드: Agent Auto-Generation, Hybrid Policy Optimization, Scalable RL

💭 이런 질문을 해본 적 있나요?

"LLM 에이전트 설정을 자동으로 생성할 수 있다면?"

"강화학습으로 에이전트를 지속적으로 개선할 수 있을까?"

"$18로 5.4% 성능 향상이 가능하다면?"

공장의 자동화 라인처럼, Youtu-Agent는 LLM 에이전트 설정을 자동 생성하고 하이브리드 정책 최적화로 지속 개선합니다. WebWalkerQA에서 71.47% pass@1, 수학/코드 태스크 최대 35% 향상을 달성했습니다. 특히 주목할 점:

자동화된 에이전트 설정 생성

확장 가능한 강화학습 모듈로 대폭 성능 향상

저비용 실습 모듈로 약 $18에 5.4% 개선

🎯 왜 이것이 게임 체인저인가? : 수동 에이전트 설계 → 자동 생성 및 자가 진화 에이전트의 전환점

🔗 더 자세한 내용이 궁금하다면 : https://arxiv.org/abs/2512.24615

매일 화요일 오전 8시,

바쁜 당신을 기술 발전에 뒤쳐지지 않게 만들어줄

최신 AI 트렌드가 요약 정리본으로 전달됩니다!