금주 캐치페이퍼는 NVIDIA, CMU, NYU, Alibaba, Meta, Scale AI, Microsoft, Google DeepMind 와 함께합니다. 3분만 투자해 쓱 둘러보고, 빠르게 바뀌는 기술의 방향성을 놓치지 마세요!

📈 최신 AI 트렌드 2줄 요약

🌟 이번 주 AI 연구에서는 LLM 에이전트의 메모리 관리, 다중 보상 강화학습 최적화, 그리고 멀티모달 검색 시스템이 핵심 트렌드로 부상했습니다.

🚀 하드웨어 병목 현상 진단부터 토큰 수준의 모델 협업까지, AI 시스템의 효율성과 확장성을 극대화하기 위한 연구가 활발히 진행되고 있습니다.

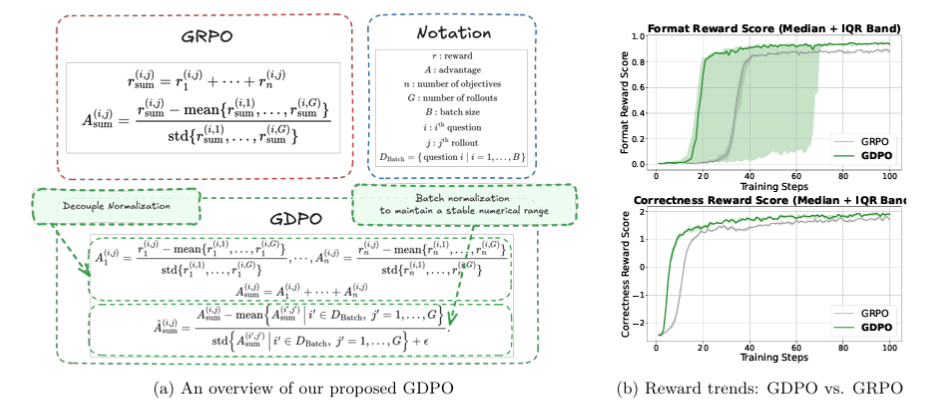

💥 "그동안 쓰던 GRPO, 사실 신호가 다 뭉개지고 있었다"

GDPO: Group reward-Decoupled Normalization Policy Optimization

🏛️ 소속: NVIDIA, HKUST

🏷️ 핵심 키워드: Multi-reward RL, Policy Optimization, Reward Signal Collapse

💭 이런 질문을 해본 적 있나요?

"왜 다중 보상으로 학습하면 성능이 기대만큼 안 나올까?"

"서로 다른 보상 신호들이 학습 과정에서 제대로 반영되고 있을까?"

"GRPO가 정말 최선의 선택일까?"

튜닝 노브를 아무리 돌려도 성능이 안 나오는 이유, 드디어 밝혀졌습니다. NVIDIA 연구진이 기존 GRPO 방식에서 서로 다른 보상 조합들이 동일한 어드밴티지 값으로 붕괴되는 치명적 결함을 발견했습니다. 새롭게 제안된 GDPO는 각 보상을 개별적으로 정규화하여 이 문제를 해결합니다. 특히 주목할 점:

기존 방식 대비 우수성: AIME 벤치마크에서 수학 추론 정확도 최대 6.3% 향상

경쟁 대상들과의 비교 우위: 도구 호출, 코드 생성 등 모든 태스크에서 GRPO를 일관되게 압도

규모/일관성/적용범위의 확장성: verl, TRL에 드롭인 교체 가능한 실용성

🎯 왜 이것이 게임 체인저인가? : 보상 신호 붕괴를 방치한 기존 방식 → 정보 손실 없는 다중 보상 최적화의 전환점 강조

🔗 더 자세한 내용이 궁금하다면 : 논문 링크

🧠 "Shannon 정보 이론, 70년간 틀린 질문을 하고 있었다"

From Entropy to Epiplexity: Rethinking Information for Computationally Bounded Intelligence

🏛️ 소속: Carnegie Mellon University, New York University

🏷️ 핵심 키워드: Epiplexity, Information Theory, Computationally Bounded Observers

💭 이런 질문을 해본 적 있나요?

"왜 데이터 순서를 바꾸면 학습 결과가 달라질까?"

"결정론적 변환으로 정보가 '생성'될 수 있을까?"

"모델이 실제로 학습할 수 있는 정보량은 얼마나 될까?"

Shannon 엔트로피가 측정하지 못한 것이 있습니다. 무한한 계산 능력을 가정한 기존 정보 이론과 달리, 'Epiplexity'는 계산적으로 제한된 관찰자가 실제로 학습할 수 있는 구조적 정보를 정량화합니다. 이는 "계산이 정보를 생성할 수 있다"는 역설적 현상을 수학적으로 설명합니다. 특히 주목할 점:

기존 방식 대비 우수성: 고전 정보 이론의 3가지 패러독스를 해결

경쟁 대상들과의 비교 우위: 데이터 가치 평가에 새로운 이론적 기반 제공

규모/일관성/적용범위의 확장성: 높은 epiplexity와 OOD 일반화 성능 간 상관관계 입증

🎯 왜 이것이 게임 체인저인가? : 무제한 계산 가정의 추상적 정보 이론 → 현실적 학습자 관점의 실용적 정보 측정으로의 전환점 강조

🔗 더 자세한 내용이 궁금하다면 : 논문 링크

🔍 "텍스트, 이미지, 비디오를 하나의 공간에서 검색한다고?"

Qwen3-VL-Embedding and Qwen3-VL-Reranker

🏛️ 소속: Alibaba Tongyi Lab

🏷️ 핵심 키워드: Multimodal Retrieval, Embedding, Cross-modal Understanding

💭 이런 질문을 해본 적 있나요?

"이미지와 텍스트를 동시에 검색하는 게 가능할까?"

"비디오 속 특정 장면을 텍스트로 찾을 수 있을까?"

"30개 이상의 언어를 지원하는 통합 검색 시스템이 있을까?"

검색의 미래가 도착했습니다. Alibaba가 텍스트, 이미지, 스크린샷, 비디오를 하나의 표현 공간에서 처리하는 멀티모달 임베딩-리랭킹 파이프라인을 공개했습니다. 플래그십 8B 모델은 MMEB-V2에서 77.8점을 기록하며 오픈소스 1위를 차지했습니다. 특히 주목할 점:

기존 방식 대비 우수성: 기존 최고 오픈소스 모델 대비 6.7% 성능 향상

경쟁 대상들과의 비교 우위: 2단계(임베딩+리랭킹) 접근으로 검색 정확도 극대화

규모/일관성/적용범위의 확장성: Matryoshka 표현 학습으로 유연한 임베딩 차원 지원

🎯 왜 이것이 게임 체인저인가? : 단일 모달리티 검색 → 진정한 멀티모달 통합 검색의 전환점 강조

🔗 더 자세한 내용이 궁금하다면 : 논문 링크

🧩 "AI 에이전트가 스스로 기억을 관리한다면?"

AgeMem: Agentic Memory for LLM Agents

🏛️ 소속: Alibaba

🏷️ 핵심 키워드: Memory Management, Long-term Memory, Short-term Memory, Reinforcement Learning

💭 이런 질문을 해본 적 있나요?

"에이전트가 어떤 정보를 기억하고 버릴지 스스로 결정할 수 있을까?"

"장기 기억과 단기 기억을 하나의 정책으로 통합할 수 있을까?"

"컨텍스트 윈도우 한계를 어떻게 극복할 수 있을까?"

기억을 다루는 방식이 완전히 달라집니다. AgeMem은 메모리 연산을 도구 기반 액션으로 노출시켜, LLM 에이전트가 저장, 검색, 업데이트, 요약, 삭제를 자율적으로 결정하도록 합니다. 3단계 점진적 강화학습 전략으로 통합된 메모리 관리 행동을 학습합니다. 특히 주목할 점:

기존 방식 대비 우수성: 기존 메모리 증강 베이스라인 대비 평균 4.82~8.57%p 성능 향상

경쟁 대상들과의 비교 우위: 휴리스틱이나 보조 컨트롤러 없이 엔드투엔드 최적화

규모/일관성/적용범위의 확장성: 5개 장기 추론 벤치마크에서 일관된 성능 향상

🎯 왜 이것이 게임 체인저인가? : 분리된 메모리 시스템 → 통합된 자율 메모리 관리의 전환점 강조

🔗 더 자세한 내용이 궁금하다면 : 논문 링크

⚡ "토큰 하나하나마다 최적의 전문가를 고른다고?"

FusionRoute: Token-Level LLM Collaboration

🏛️ 소속: Meta AI

🏷️ 핵심 키워드: Multi-LLM Collaboration, Expert Routing, Token-level Selection

💭 이런 질문을 해본 적 있나요?

"여러 전문 모델의 장점을 하나로 합칠 수 있을까?"

"문장 단위가 아닌 토큰 단위로 모델을 선택하면 어떨까?"

"작은 라우터가 대형 모델들을 효과적으로 조율할 수 있을까?"

각 토큰마다 최적의 전문가를 선택하는 시대가 왔습니다. FusionRoute는 경량 라우터가 매 디코딩 스텝마다 가장 적합한 전문 모델을 선택하고, 동시에 보완적인 로짓을 생성해 전문가의 출력을 정제합니다. 이론적으로 기존 전문가 전용 라우팅의 한계를 증명하고 이를 극복했습니다. 특히 주목할 점:

기존 방식 대비 우수성: 시퀀스/토큰 수준 협업, 모델 머징, 직접 파인튜닝 모두 능가

경쟁 대상들과의 비교 우위: Llama-3, Gemma-2 패밀리에서 일관된 성능 향상

규모/일관성/적용범위의 확장성: 수학 추론, 코드 생성, 지시 따르기 전반에서 효과적

🎯 왜 이것이 게임 체인저인가? : 단일 모델 또는 조잡한 앙상블 → 정밀한 토큰 수준 전문가 협업의 전환점 강조

🔗 더 자세한 내용이 궁금하다면 : 논문 링크

📋 "코드 실행 없이 패치 품질을 평가한다고?"

Agentic Rubrics as Contextual Verifiers for SWE Agents

🏛️ 소속: Scale AI

🏷️ 핵심 키워드: Software Engineering Agents, Verification, Test-Time Scaling

💭 이런 질문을 해본 적 있나요?

"코드 실행 환경 없이도 패치를 평가할 수 있을까?"

"RL 보상 신호를 더 효율적으로 생성할 방법은 없을까?"

"왜 테스트가 놓치는 문제들이 있을까?"

테스트 실행의 병목에서 벗어나는 방법이 있을까요? Scale AI의 Agentic Rubrics는 전문 에이전트가 코드베이스와 상호작용하며 맥락 기반 체크리스트를 생성하고, 코드 실행 없이 패치를 평가합니다. SWE-Bench Verified에서 54.2%를 달성하며 최강 베이스라인 대비 3.5%p 이상 향상됐습니다. 특히 주목할 점:

기존 방식 대비 우수성: 코드 실행 없이도 ground-truth 테스트와 일관된 평가

경쟁 대상들과의 비교 우위: 테스트가 잡지 못하는 문제까지 플래그

규모/일관성/적용범위의 확장성: 해석 가능한 진단 피드백 제공

🎯 왜 이것이 게임 체인저인가? : 실행 기반 검증의 확장성 한계 → 맥락 기반 에이전틱 검증의 전환점 강조

🔗 더 자세한 내용이 궁금하다면 : 논문 링크

🚨 "당신의 AI 에이전트, 이미 감염됐을 수 있다"

BackdoorAgent: A Unified Framework for Backdoor Attacks on LLM-based Agents

🏛️ 소속: Alibaba, Fudan University

🏷️ 핵심 키워드: Backdoor Attacks, Agent Security, Multi-stage Vulnerability

💭 이런 질문을 해본 적 있나요?

"에이전트 워크플로우 전체가 공격 표면이 될 수 있을까?"

"계획 단계에 주입된 트리거가 도구 사용까지 영향을 미칠까?"

"기존 백도어 연구가 에이전트 환경의 위험을 제대로 다루고 있을까?"

에이전트의 자율성이 높아질수록 공격 표면도 넓어집니다. BackdoorAgent는 LLM 에이전트의 계획, 메모리, 도구 사용 3단계 전반에 걸친 백도어 위협을 체계적으로 분석하는 최초의 통합 프레임워크입니다. GPT 백본 기준 메모리 공격 77.97%, 도구 공격 60.28%의 트리거 지속률을 확인했습니다. 특히 주목할 점:

기존 방식 대비 우수성: 단일 공격 벡터 분석을 넘어 교차 단계 전파까지 분석

경쟁 대상들과의 비교 우위: Agent QA, Code, Web, Drive 4개 앱 벤치마크 제공

규모/일관성/적용범위의 확장성: 언어 전용 및 멀티모달 설정 모두 커버

🎯 왜 이것이 게임 체인저인가? : 단편적 공격 분석 → 에이전트 중심 통합 보안 평가의 전환점 강조

🔗 더 자세한 내용이 궁금하다면 : 논문 링크

🎮 "마인크래프트에서 AI 에이전트의 기억력을 테스트한다고?"

MineNPC-Task: Task Suite for Memory-Aware Minecraft Agents

🏛️ 소속: Microsoft Research

🏷️ 핵심 키워드: Minecraft Agents, Memory-Aware, Mixed-Initiative, Benchmark

💭 이런 질문을 해본 적 있나요?

"오픈월드 환경에서 에이전트의 기억 능력을 어떻게 평가할까?"

"합성 프롬프트가 아닌 실제 사용자 태스크로 테스트할 수 있을까?"

"에이전트가 얼마나 자연스럽게 인간과 협력할 수 있을까?"

게임 속에서 AI의 진짜 실력이 드러납니다. MineNPC-Task는 전문 플레이어와의 실제 협력 플레이에서 도출한 태스크로 메모리 인식 LLM 에이전트를 평가합니다. GPT-4o 기준 서브태스크 실패율 약 33%로, 주로 코드 실행 오류가 원인이었지만 효과적인 인간-에이전트 공동 적응도 관찰됐습니다. 특히 주목할 점:

기존 방식 대비 우수성: 합성 프롬프트 대신 실제 사용자 저작 태스크 사용

경쟁 대상들과의 비교 우위: bounded-knowledge 정책으로 현실적 평가

규모/일관성/적용범위의 확장성: 투명한 커뮤니케이션의 중요성 입증

🎯 왜 이것이 게임 체인저인가? : 합성 벤치마크 → 실제 협력 시나리오 기반 평가의 전환점 강조

🔗 더 자세한 내용이 궁금하다면 : 논문 링크

📊 "배치 사이즈, 지금까지 잘못 설정하고 있었다"

How to Set the Batch Size for Large-Scale Pre-training?

🏛️ 소속: Shanghai AI Laboratory, Shanghai JiaoTong University

🏷️ 핵심 키워드: Batch Size, Pre-training, WSD Scheduler, Dynamic Scheduling

💭 이런 질문을 해본 적 있나요?

"Warmup-Stable-Decay 스케줄러에서 최적의 배치 사이즈는?"

"학습 중간에 배치 사이즈를 동적으로 조절하면 어떨까?"

"기존 배치 사이즈 이론이 현대 LLM 학습에도 적용될까?"

대규모 사전학습의 숨겨진 변수를 공략합니다. 연구진은 현대 LLM 사전학습에서 널리 사용되는 WSD 스케줄러 환경에서 배치 사이즈 역학을 재평가하고, 새로운 동적 배치 사이즈 스케줄링 전략을 제안했습니다. Qwen3 MoE 및 Dense 모델에서 더 낮은 학습 손실과 MMLU, CMMLU 벤치마크 성능 향상을 달성했습니다. 특히 주목할 점:

기존 방식 대비 우수성: 고정 배치 사이즈 대비 일관된 성능 향상

경쟁 대상들과의 비교 우위: 새로운 이론적 프레임워크 기반

규모/일관성/적용범위의 확장성: 대규모 사전학습에 실용적 가이던스 제공

🎯 왜 이것이 게임 체인저인가? : 경험적 배치 사이즈 선택 → 이론 기반 동적 스케줄링의 전환점 강조

🔗 더 자세한 내용이 궁금하다면 : 논문 링크

🔧 "GPU가 문제가 아니었다, 메모리와 인터커넥트가 병목이다"

Challenges and Research Directions for Large Language Model Inference Hardware

🏛️ 소속: Google DeepMind

🏷️ 핵심 키워드: LLM Inference, Hardware Bottleneck, Memory, Interconnect

💭 이런 질문을 해본 적 있나요?

"왜 LLM 추론은 학습과 완전히 다른 하드웨어 특성을 가질까?"

"오토리그레시브 디코딩의 진짜 병목은 무엇일까?"

"차세대 AI 하드웨어는 어떤 방향으로 발전해야 할까?"

컴퓨팅 파워만 늘린다고 해결되지 않습니다. Google DeepMind 연구진이 LLM 추론의 핵심 병목이 연산이 아닌 메모리와 인터커넥트 지연임을 진단했습니다. 이를 해결하기 위한 4가지 하드웨어 연구 방향을 제시합니다: HBM급 대역폭의 10배 용량 플래시, Processing-Near-Memory, 3D 메모리-로직 스태킹, 저지연 인터커넥트. 특히 주목할 점:

기존 방식 대비 우수성: 연산 중심 최적화의 한계를 명확히 진단

경쟁 대상들과의 비교 우위: MoE, 추론 모델, 멀티모달, RAG 트렌드까지 분석

규모/일관성/적용범위의 확장성: 데이터센터와 모바일 환경 모두 고려

🎯 왜 이것이 게임 체인저인가? : 연산 중심 하드웨어 설계 → 메모리/인터커넥트 중심 아키텍처의 전환점 강조

🔗 더 자세한 내용이 궁금하다면 : 논문 링크

매일 화요일 오전 8시,

바쁜 당신을 기술 발전에 뒤쳐지지 않게 만들어줄

최신 AI 트렌드가 요약 정리본으로 전달됩니다!