금주 캐치페이퍼는 Meta AI, DeepSeek, NVIDIA, NYU, Tencent, Google, Cohere, Alibaba, Microsoft와 함께합니다.

3분만 투자해 쓱 둘러보고, 빠르게 바뀌는 기술의 방향성을 놓치지 마세요!

📈 최신 AI 트렌드 3줄 요약

🌟 이번 주 AI 연구에서는 Transformer 아키텍처의 근본적 재설계와 LLM 추론 효율화가 핵심 화두입니다.

🔎 NVIDIA와 Google이 각각 KV 캐시 압축과 모델 병합 최적화로 실용적 돌파구를 제시했습니다.

🚀 로보틱스 분야에서는 VLA 모델의 추론 지연 문제 해결이 급물살을 타고 있으며, MoE 모델의 내부 작동 원리를 밝히는 해석 가능성 연구가 새로운 성능 향상 경로를 열고 있습니다.

🧠 5년간 불변이던 Transformer FFN, Meta가 드디어 손댔다

STEM: Scaling Transformers with Embedding Modules

🏛️ 소속: Carnegie Mellon University, Meta AI

🏷️ 핵심 키워드: Transformer, FFN Replacement, Token Embeddings, Training ROI

💭 이런 질문을 해본 적 있나요?

"Transformer의 FFN 레이어가 정말 최선의 설계일까?"

"학습 안정성과 성능을 동시에 잡을 수 있는 방법은 없을까?"

"같은 컴퓨팅 자원으로 더 높은 ROI를 얻을 수 있을까?"

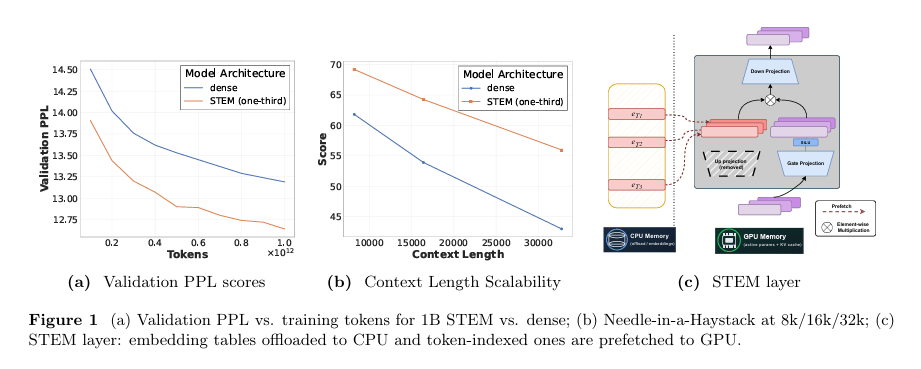

레고 블록을 더 효율적인 부품으로 교체하듯, STEM은 Transformer FFN의 up-projection을 토큰 인덱스 임베딩으로 대체합니다. 이 단순한 변화가 학습 안정성을 높이고, 지식 집약 태스크에서 최대 10% 성능 향상을 이끌어냈습니다. 특히 주목할 점:

기존 FFN 대비 학습 안정성과 장문맥 이해력 동시 향상

1.33배 높은 학습 ROI로 동일 자원 대비 효율 극대화

기존 Transformer에 플러그인 방식으로 적용 가능한 확장성

🎯 왜 이것이 게임 체인저인가? : 고정된 FFN 구조 → 임베딩 기반 유연한 지식 저장 방식의 전환점 강조

🔗 더 자세한 내용이 궁금하다면 : https://arxiv.org/abs/2601.10639

💾 DeepSeek이 LLM에 "외장 뇌"를 달았다

Engram: Conditional Memory via Scalable Lookup

🏛️ 소속: Peking University, DeepSeek

🏷️ 핵심 키워드: Conditional Memory, Knowledge Lookup, Sparsity, Parameter Scaling

💭 이런 질문을 해본 적 있나요?

"LLM 파라미터를 늘리지 않고 지식을 확장할 수 있을까?"

"추론 비용 증가 없이 모델 성능을 높일 방법은?"

"희소성의 새로운 축을 만들 수 있을까?"

인간의 해마가 필요한 기억만 꺼내 쓰듯, Engram은 LLM에 조건부 메모리 모듈을 추가해 효율적인 지식 검색을 가능하게 합니다. 파라미터를 공격적으로 확장하면서도 추론 오버헤드는 최소화하는, 희소성의 새로운 차원을 열었습니다. 특히 주목할 점:

기존 dense 모델 대비 추론 비용 최소화하며 성능 향상

다양한 벤치마크에서 일관된 개선 효과 입증

MoE와 다른 방식의 새로운 희소성 축 제시

🎯 왜 이것이 게임 체인저인가? : 파라미터 증가 = 비용 증가 공식 → 조건부 메모리로 효율적 확장의 전환점 강조

🔗 더 자세한 내용이 궁금하다면 : https://arxiv.org/abs/2601.07372

🎬 NVIDIA가 비디오 생성 속도의 벽을 부쉈다

TMD: Transition Matching Distillation for Fast Video Generation

🏛️ 소속: NVIDIA, New York University

🏷️ 핵심 키워드: Video Diffusion, Distillation, Few-Step Generation, Real-Time

💭 이런 질문을 해본 적 있나요?

"비디오 생성에 왜 이렇게 오래 걸릴까?"

"품질을 유지하면서 생성 속도를 획기적으로 높일 수 있을까?"

"실시간 비디오 생성이 정말 가능해질까?"

마라톤 선수를 단거리 스프린터로 훈련시키듯, TMD는 대형 비디오 확산 모델을 소수 스텝 생성기로 증류합니다. 시각적 품질과 프롬프트 충실도를 유지하면서 추론 스텝을 대폭 줄여, 실시간 비디오 생성의 문을 열었습니다. 특히 주목할 점:

기존 비디오 확산 모델 대비 추론 스텝 대폭 감소

고품질 유지와 프롬프트 정합성 동시 달성

실시간 애플리케이션 적용 가능성 입증

🎯 왜 이것이 게임 체인저인가? : 느린 다단계 생성 → 소수 스텝 실시간 생성의 전환점 강조

🔗 더 자세한 내용이 궁금하다면 : https://arxiv.org/abs/2601.09881

🤖 로봇이 "생각하는 시간" 89% 단축됐다

Fast-ThinkAct: Efficient Vision-Language-Action Reasoning via Verbalizable Latent Planning

🏛️ 소속: NVIDIA 및 다기관 공동연구

🏷️ 핵심 키워드: VLA Models, Latent Planning, Inference Latency, Robotic Manipulation

💭 이런 질문을 해본 적 있나요?

"로봇이 생각하느라 멈춰 있는 시간을 줄일 수 있을까?"

"복잡한 추론과 빠른 실행을 동시에 달성할 수 있을까?"

"실패 상황에서 로봇이 스스로 복구할 수 있을까?"

체스 고수가 직관적으로 수를 두듯, Fast-ThinkAct는 언어화 가능한 잠재 계획을 통해 VLA 모델의 추론 지연을 최대 89.3% 줄였습니다. 로봇 조작, 장기 계획, 실패 복구, 퓨샷 적응 모두에서 SOTA를 달성했습니다. 특히 주목할 점:

기존 VLA 모델 대비 추론 지연 89.3% 감소

로봇 조작 벤치마크에서 SOTA 성능 달성

실패 복구 및 퓨샷 적응 능력까지 탑재

🎯 왜 이것이 게임 체인저인가? : 느린 명시적 추론 → 빠른 잠재 계획 기반 실행의 전환점 강조

🔗 더 자세한 내용이 궁금하다면 : https://arxiv.org/abs/2601.09708

🎛️ Tencent가 LLM의 "인지 스위치"를 발견했다

RISER: Orchestrating Latent Reasoning Skills for Adaptive Activation Steering

🏛️ 소속: Tongji University, Tencent

🏷️ 핵심 키워드: Activation Steering, Cognitive Primitives, Router, Token Efficiency

💭 이런 질문을 해본 적 있나요?

"LLM의 추론 능력을 동적으로 조절할 수 있을까?"

"Chain-of-Thought 없이도 정확한 추론이 가능할까?"

"모델 내부의 인지 기능을 분리해서 조합할 수 있을까?"

DJ가 믹서로 음악을 조합하듯, RISER는 학습된 라우터로 잠재적 "인지 프리미티브"를 동적으로 조합합니다. 추론 정확도 6.5% 향상과 함께 Chain-of-Thought 대비 2~3배 토큰 효율을 달성했습니다. 특히 주목할 점:

기존 정적 스티어링 대비 동적·조합적 접근의 우수성

CoT 대비 2~3배 토큰 효율로 비용 절감

다양한 추론 태스크에서 6.5% 절대 정확도 향상

🎯 왜 이것이 게임 체인저인가? : 고정된 추론 경로 → 동적 인지 프리미티브 조합의 전환점 강조

🔗 더 자세한 내용이 궁금하다면 : https://arxiv.org/abs/2601.09269

🎨 Google, 이미지 편집의 "본질"을 건드리다

Alterbute: Editing Intrinsic Attributes of Objects in Images

🏛️ 소속: Google, The Hebrew University of Jerusalem

🏷️ 핵심 키워드: Intrinsic Attributes, Diffusion, Object Identity, Scene Preservation

💭 이런 질문을 해본 적 있나요?

"물체의 색상만 바꾸면서 정체성은 유지할 수 있을까?"

"질감, 재질, 형태를 자유롭게 편집할 수 있을까?"

"배경과 맥락을 해치지 않는 정밀한 편집이 가능할까?"

조각가가 대리석의 질감만 바꾸듯, Alterbute는 객체의 색상·질감·재질·형태 같은 본질적 속성을 편집하면서도 정체성과 장면 맥락을 완벽히 보존합니다. 사용자 선호도 연구와 VLM 평가 모두에서 기존 방법을 압도했습니다. 특히 주목할 점:

기존 이미지 편집 대비 본질적 속성에 집중한 정밀한 제어

객체 정체성과 장면 맥락 동시 보존

사용자 연구 및 VLM 평가에서 우수한 성능 입증

🎯 왜 이것이 게임 체인저인가? : 전체 이미지 편집 → 본질적 속성만 선택적으로 편집하는 전환점 강조

🔗 더 자세한 내용이 궁금하다면 : https://arxiv.org/abs/2601.10714

🔀 "모델 합치기"의 정답을 찾았다!

SimMerge: Learning to Select Merge Operators from Similarity Signals

🏛️ 소속: Google, Cohere

🏷️ 핵심 키워드: Model Merging, Similarity Signals, Merge Operators, Transfer Learning

💭 이런 질문을 해본 적 있나요?

"여러 모델을 합칠 때 최적의 방법을 어떻게 찾을까?"

"비싼 실험 없이 병합 효과를 예측할 수 있을까?"

"작은 모델에서 찾은 방법이 초대형 모델에도 통할까?"

요리사가 재료의 궁합을 직감으로 아는 것처럼, SimMerge는 저렴한 사전 병합 유사도 신호만으로 최적의 병합 연산자를 예측합니다. 비용 많이 드는 실험 탐색 없이 성능 격차의 65%를 메우고, 111B 모델까지 재훈련 없이 전이됩니다. 특히 주목할 점:

기존 고정 연산자(41.8%) 대비 65.0% 성능 격차 해소

비싼 경험적 탐색 과정 완전 제거

111B 파라미터 모델까지 재훈련 없이 전이 가능

🎯 왜 이것이 게임 체인저인가? : 시행착오 기반 병합 → 예측 기반 최적 병합의 전환점 강조

🔗 더 자세한 내용이 궁금하다면 : https://arxiv.org/abs/2601.09473

📝 AI의 "자기 비평 능력"을 업그레이드하다

RM-NLHF: Reward Modeling from Natural Language Human Feedback

🏛️ 소속: Alibaba Group, Tongyi Lab

🏷️ 핵심 키워드: Generative Reward Model, Process Supervision, Critique Quality, NLHF

💭 이런 질문을 해본 적 있나요?

"AI가 올바른 답을 고르면서 왜 엉뚱한 설명을 할까?"

"제한된 인간 피드백으로 프로세스 수준 감독을 확장할 수 있을까?"

"AI의 비평 품질과 추론 정렬을 동시에 높일 수 있을까?"

훌륭한 선생님이 정답뿐 아니라 풀이 과정도 점검하듯, RM-NLHF는 온라인 메타 보상 모델로 제한된 인간 비평에서 프로세스 수준 감독을 확장합니다. "결과-과정 불일치" 문제를 해결하며 비평 품질과 추론 정렬을 대폭 향상시켰습니다. 특히 주목할 점:

기존 GRM의 "정답은 맞추지만 설명은 틀리는" 문제 해결

제한된 인간 비평만으로 프로세스 감독 스케일링

다양한 벤치마크에서 성능, 비평 품질, 추론 정렬 동시 향상

🎯 왜 이것이 게임 체인저인가? : 결과 중심 보상 → 과정 중심 자연어 피드백 보상의 전환점 강조

🔗 더 자세한 내용이 궁금하다면 : https://arxiv.org/abs/2601.07349

🧬 MoE 모델의 "뇌 지도"에 대한 새로운 혁신

What Gets Activated: Uncovering Domain and Driver Experts in MoE Language Models

🏛️ 소속: Guangdong University of Technology, Microsoft

🏷️ 핵심 키워드: MoE Interpretability, Domain Experts, Driver Experts, Expert Activation

💭 이런 질문을 해본 적 있나요?

"MoE 모델에서 어떤 전문가가 실제로 중요한 역할을 할까?"

"특정 도메인에 특화된 전문가를 찾을 수 있을까?"

"전문가 가중치 조정으로 성능을 높일 수 있을까?"

뇌의 기능 영역을 매핑하듯, 이 연구는 MoE 모델에서 "도메인 전문가"와 "드라이버 전문가"를 구분합니다. 문장 초반 토큰이 드라이버 전문가를 더 많이 활성화하며, 두 유형의 가중치 조정으로 모든 모델과 도메인에서 유의미한 성능 향상을 달성했습니다. 특히 주목할 점:

MoE 전문가 수준의 해석 가능성 연구로 새로운 영역 개척

도메인 선호 전문가 vs 인과적 영향력 전문가 구분

가중치 조정만으로 3개 모델, 3개 도메인 모두 성능 향상

🎯 왜 이것이 게임 체인저인가? : 블랙박스 MoE → 전문가 역할 이해 기반 최적화의 전환점 강조

🔗 더 자세한 내용이 궁금하다면 : https://arxiv.org/abs/2601.10159

⚡ NVIDIA가 KV 캐시를 4분의 1로 줄였다

KVzap: Fast, Adaptive, and Faithful KV Cache Pruning

🏛️ 소속: NVIDIA

🏷️ 핵심 키워드: KV Cache, Pruning, Compression, LLM Inference

💭 이런 질문을 해본 적 있나요?

"LLM 추론 시 메모리 병목을 어떻게 해결할까?"

"정확도 손실 없이 KV 캐시를 압축할 수 있을까?"

"입력에 따라 적응적으로 캐시를 관리할 수 있을까?"

필요한 책만 책상에 올려두듯, KVzap은 입력에 적응적으로 KV 캐시를 프루닝해 2~4배 압축을 달성합니다. 정확도 손실은 거의 없으며, NVIDIA KVpress 리더보드에서 기존 모든 방법을 제치고 1위를 차지했습니다. 특히 주목할 점:

기존 프루닝 방법 대비 2~4배 압축률로 압도적 우위

정확도 손실 거의 없는 충실한 압축

LLM 추론 엔진에 효율적으로 통합 가능한 설계

🎯 왜 이것이 게임 체인저인가? : 정적 캐시 관리 → 입력 적응형 지능적 프루닝의 전환점 강조

🔗 더 자세한 내용이 궁금하다면 : https://arxiv.org/abs/2601.07891

매주 화요일 오전 8시,

바쁜 당신을 기술 발전에 뒤쳐지지 않게 만들어줄

최신 AI 트렌드가 요약 정리본으로 전달됩니다!